Tạo Robots.txt cho website WordPress. Robots.txt là một phần không thể thiếu của một website. Nó giúp bạn quản lý việc thu thập dữ liệu trên website của bạn một các hiệu quả.

1.Robots.txt là gì ?

Đầu tiên chúng ta hãy đi tìm hiểu robots.txt là gì?

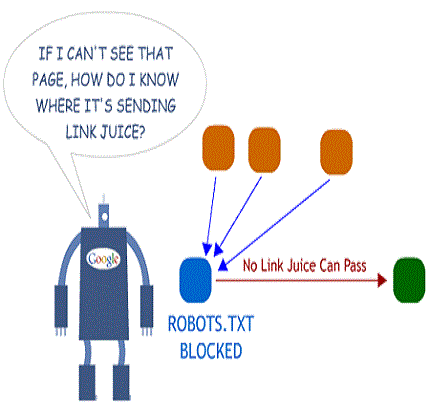

Robots.txt giúp cho các webmaster linh hoạt hơn trong việc quản lý bot của các công cụ tìm kiếm truy cập một khu vực nào đó trong website của bạn.

Robots.txt có thể quy định từng loại bot khác nhau của các SE khác nhau có thể vào website hay từng khu vực của website hay không.

Ví dụ 1:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Trong đó :

User-agent: * : câu lệnh này cho phép tất cả các loại bot

Disallow: /wp-admin/ : câu lệnh này có nghĩa là không cho bot truy cập thư mục wp-admin và tất cả những gì nằm trong thư mục wp-admin

2.Hướng dẫn sử dụng Robots.txt

A. Không cho phép bot truy cập những thư mục nào mà mình không muốn

Lấy lại ví dụ trên :

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Những câu lệnh này có nghĩa là cho phép tất cả các loại bot truy cập tất cả các thư mục trong website chỉ trừ 2 thư mục wp-admin và wp-includes

B.Không cho bot index 1 trang bất kỳ

Ta dùng câu lệnh: “ Disallow:/trang không cho bot truy cập”

Ví dụ: Disallow: /lien-he.html

C.Loại bỏ 1 hình từ Google Images

User-agent: Googlebot-Image

Disallow: /images/hinh.png

D.Chặn một bot nào đó

Ví dụ 2:

User-agent: SpamBot Disallow: / User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Những câu lệnh trong ví dụ 2 nghĩa là cấm bot SpamBot truy cập tất cả tài nguyên. Trong khi các bot khác được truy cập tất cả trừ thư mục “wp-admin ” và “wp-includes”.

Ví dụ 3:

User-agent: SpamBot Disallow: /admin/ Disallow: /includes/ Disallow: /config/config.php User-agent: * Disallow: /admin/ Disallow: /includes/

Những câu lện trong ví dụ 3 nghĩa là không cho phép SpamBot truy cập các thư mục được liệt kê như: thư mục “admin”, “includes” và và file “config.php” trong thư mục config . Còn các bot khác được truy cập mọi thứ trừ hai thư mục “admin” và “includes”.

E.sử dụng đồng thời “Allow” và “Disallow” cùng nhau

Ví dụ 4:

User-agent: Googlebot Disallow: /vidu/ Allow: /vidu/demo-thoi-nha.html

Những câu lệnh trong ví dụ 4 có nghĩa là chặn Googlebot truy cập tài nguyên có trong thư mục “vidu” .Nhưng lại có thể truy cập được trang “demo-thoi-nha.html”

Ví dụ 5:

User-agent: Googlebot Disallow: / User-agent: Googlebot-Mobile Allow: /

Những câu lệnh trong ví dụ 5 có nghĩa là chặn không cho Googlebot truy cập vào bất kỳ thư mục nào trên website, nhưng lại cho phép Googlebot-Mobile truy cập vào tất cả các thư mục trên website của bạn.

Những lỗi nên tránh khi tạo tập tin robot.txt

Khi các bạn sử dụng lại một robots.txt của ai đó hoặc tự mình tạo ra một robots.txt riêng cho website mình thì nên tránh những lỗi sau:

– Phân biệt chữ hoa chữ thường.

– Không được viết dư, thiếu khoảng trắng.

– Không nên chèn thêm bất kỳ ký tự nào khác ngoài các cú pháp lệnh.

– Mỗi một câu lệnh nên viết trên 1 dòng.

Và đây là tập tin robot.txt của mình:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /feed Disallow: /*/feed Disallow: /comments Disallow: /author Disallow: /archives Sitemap: https://thuthuattienich.com/sitemap.xml

Thuthuattienich.com

Thuthuattienich.com